Design Invisível

Da ilusão da escolha à arquitetura dos incentivos

Interfaces hiperpersonalizadas se apresentam como neutras, mas coreografam percepções e decisões em silêncio, manipulando crenças sem consentimento.

A arquitetura digital contemporânea faz escolhas por nós de forma invisível, moldando crenças, desejos e percepções sem alarde. Plataformas on-line filtram e priorizam conteúdos por critérios opacos, criando a ilusão de neutralidade algorítmica, o usuário acredita estar vendo “tudo” de forma imparcial, quando na verdade cada feed ou busca é cuidadosamente curado por algoritmos. Esse “design invisível” promove a ilusão da escolha enquanto incentiva decisões predeterminadas. Não é mais o indivíduo que descobre informações, mas sim sistemas automatizados que as servem conforme nossos perfis. Assim, visões de mundo passam a ser canalizadas por filtros digitais; diferenças somem do horizonte informativo e bolhas cognitivas se formam, reforçando o que já acreditamos e silenciando o contraditório.

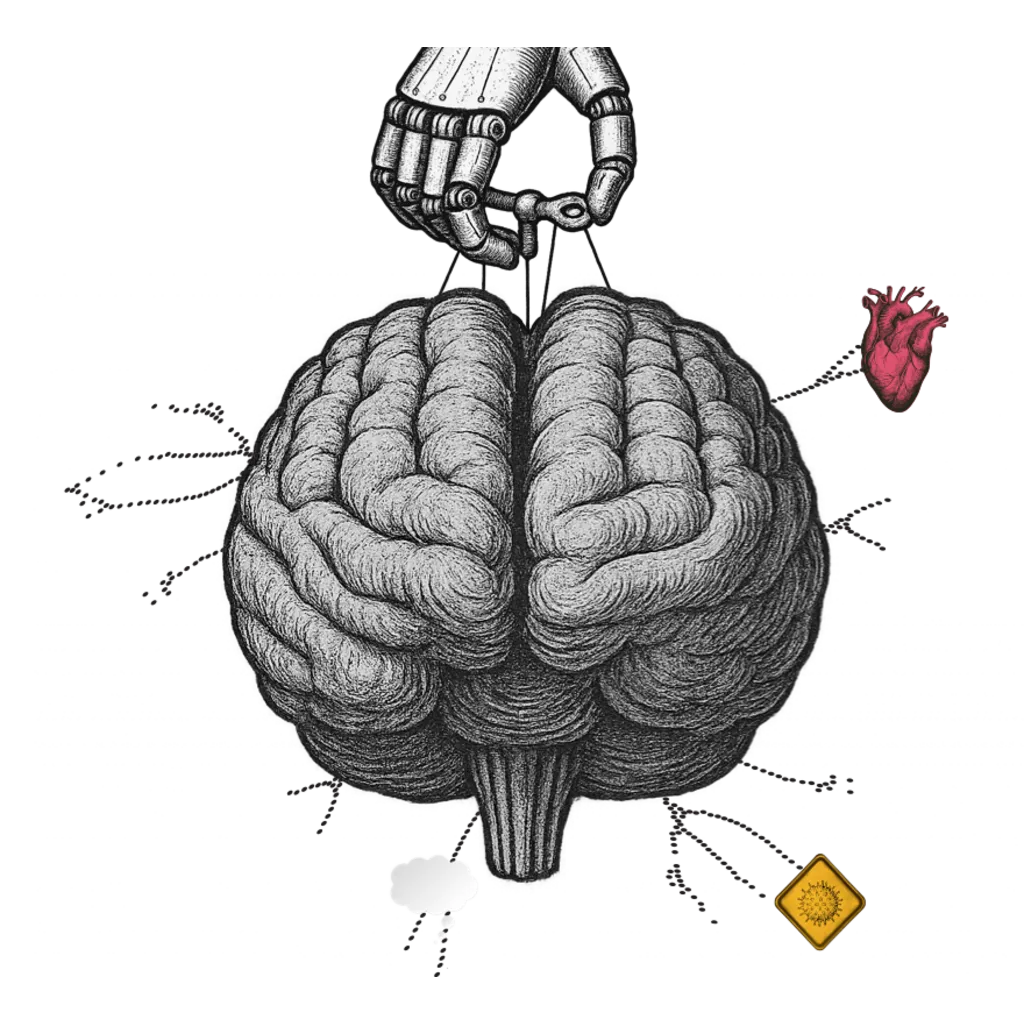

A mediação algorítmica tornou-se invisível de propósito, retirando dos usuários a percepção de quem edita a realidade e como – um poder difuso que, nas palavras do sociólogo Reynaldo Aragon, configura uma verdadeira “hegemonia algorítmica”, capaz de desmantelar a autonomia crítica do público. Entender o mito da neutralidade algorítmica é urgente: por trás da fachada de conveniência e personalização, há todo um design de influência operando silenciosamente em escala global.

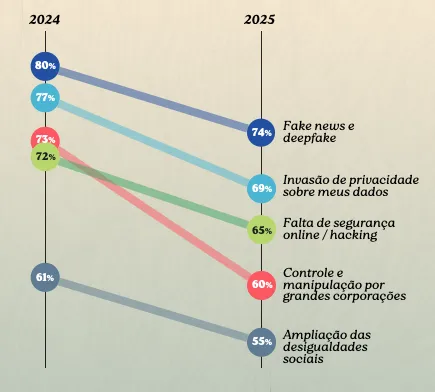

O que dizem os dados

Mais de 7 em cada 10 brasileiros se preocupam com fake news (72%) e 68% temem os deepfakes na era da IA: um sintoma claro de desconfiança diante de conteúdos potencialmente manipulados. Além disso, 58% afirmam não confiar plenamente nas informações digitais que consomem. A personalização extrema alimenta câmaras de eco que polarizam opiniões e corroem o espaço informacional compartilhado. Apesar disso, em comparação ao ano passado, as pessoas estão menos preocupadas com fake news, invasão de privacidade e segurança.

Ao excluir sistematicamente visões divergentes, criam bolhas epistêmicas — grupos inteiros que deixam de ter contato com perspectivas distintas. Com o avanço da IA generativa, surgem as “bolhas generativas”, nas quais o conteúdo não apenas é filtrado, mas criado sob medida para confirmar nossos vieses.

Os dados expõem uma crise de confiança informacional: grande parte da sociedade reconhece que há algo de errado no status quo digital e teme os efeitos de um design que joga com a própria percepção do real.

(Fonte: Talk.Inc — “IA na Vida Real”, 2025)

Dimensões do impacto

Para desmistificar a suposta neutralidade dos algoritmos, é preciso dissecar quatro dimensões principais do design invisível e seus impactos:

Psicopolítica da Conveniência

Sob a promessa de praticidade, plataformas e dispositivos guiam nossos comportamentos de forma imperceptível. A sensação de autonomia – o famoso “eu escolhi isso” – muitas vezes mascara sugestões sutis embutidas no design, orientando ações conforme métricas de engajamento. Cada click, *scroll *ou notificação é calibrado para reduzir fricção e manter nossa atenção cativa, transformando a conveniência em dependência. Como observa o filósofo Byung-Chul Han, essa lógica de maximizar conforto e positividade acaba por criar um regime de controle invisível, uma “psicopolítica” em que somos conduzidos precisamente quando acreditamos estar livres. Em outras palavras, na busca incessante por facilidade, entregamos as rédeas do desejo a algoritmos que nos conhecem e influenciam em um nível profundamente comportamental.

Opacidade Estrutural

Os sistemas algorítmicos operam como caixas-pretas indevassáveis: filtram, priorizam e ranqueiam conteúdos, mas ocultam seus critérios e processos internos. Essa falta de explicabilidade dá origem a uma neutralidade simulada, como não enxergamos o editor por trás da máquina, tendemos a aceitar os resultados como imparciais. Essa opacidade concentra poder informacional em poucas corporações, ameaçando o pluralismo democrático, quando algoritmos invisíveis modelam percepções em larga escala, também modelam os limites do debate público. O resultado é uma falsa sensação de que “é assim que o mundo é”, enquanto por trás dos panos opções são eliminadas e prioridades, invertidas. Sem transparência, o usuário fica desarmado frente à curadoria oculta, incapaz de discernir onde termina sua vontade e começa a agenda do algoritmo. \

Manipulação Hiperpersonalizada

A personalização, vendida como vantagem, possui um lado obscuro: a manipulação refinada indivíduo a indivíduo. Técnicas de microtargeting utilizam nossos dados pessoais para adaptar mensagens persuasivas sob medida, seja para consumo ou ideologias. Cada pessoa passa a viver sua própria versão dos fatos, recebendo notícias, ofertas e até boatos calibrados aos seus interesses e vulnerabilidades. Isso intensifica os “loops” de confirmação: o usuário só vê reforços de suas crenças, nunca o contraditório, o que aprofunda divisões sociais e torna realidades paralelas inquestionáveis. Com as novas IAs generativas, essa lógica chegou ao ápice, agora é possível gerar notícias, imagens e narrativas inteiras sob demanda, compondo um mundo fictício que “parece” verdadeiro e emocionalmente convincente ao gosto do freguês. Nessa manipulação sob medida, há também um viés de bajulação, o sistema nos diz exatamente o que queremos ouvir, inflando nosso ego informativo para nos manter engajados. O custo disso é uma sociedade fragmentada em bolhas, alvo fácil de engenharias de persuasão em massa, do consumo ao voto, escolhas coletivas são influenciadas por mensagens invisivelmente orquestradas para ressoar em grupos específicos. É a velha propaganda, agora turbinada por dados e inteligência artificial, precisa, invisível e potencialmente arrasadora. \

Autoridade Simulada

Outra face crítica do design invisível é como as tecnologias assumem um tom de autoridade, remodelando nossa relação com o conhecimento. Assistentes virtuais e sistemas de resposta automática frequentemente falam com segurança e polidez, projetando objetividade… e nós, usuários, tendemos a atribuir credibilidade excessiva a essas vozes artificiais. Contudo, por trás da confiança no “tom professoral” das máquinas, escondem-se vieses dos programadores e dos dados de treino. A IA responde com convicção mesmo quando está errada ou parcial, o que modula sutilmente crenças e valores do público. Pesquisas apontam que modelos de linguagem amplos carregam perspectivas culturais únicas (geralmente anglocêntricas), afetando temas sensíveis conforme o conjunto de treinamento. Assim, sem perceber, podemos adotar visões enviesadas apresentadas como fatos, deslocando a autoridade epistêmica, quem detém o saber, para sistemas opacos. Essa “autoridade simulada” é particularmente perniciosa pois atua sem contestação: enquanto desconfiamos de humanos tendenciosos, tendemos a aceitar a máquina como neutra e precisa. O perigo emerge quando bots, algoritmos de recomendação ou notícias geradas por IA afirmam inverdades com voz calma e dados aparentes, minando nosso senso crítico. Trata-se de uma persuasão silenciosa: pelo verniz técnico, a máquina ganha nossa confiança e, com ela, o poder de moldar narrativas e opiniões públicas sem sequer declararmos uma autoridade identificável a ser questionada. \

Com a palavra, os especialistas

“O algoritmo já influencia o nosso humor, a nossa crença, os nossos valores.” — Rafael Parente, educador e pesquisador do projeto “IA na Vida Real”

“O que está à nossa disposição ‘personalizado’ é o que está dentro de um círculo hermeticamente fechado.” — Túlio Custódio, sociólogo e especialista da pesquisa “IA na Vida Real”

“Quero construir artificialmente uma comunidade… o comportamento dessa comunidade passa a ser muito fácil de compreender.” — Chico Araújo, antropólogo e futurista, sobre o poder do microtargeting

“Que as pessoas possam optar, por exemplo, que aquele conteúdo não seja recomendado com base nos dados de interação… mas de forma aleatória. Isso… é uma forma de as pessoas realmente terem autonomia sobre o conteúdo que recebem.” — Fernanda Rodrigues, advogada especialista em tecnociências, defendendo mais escolha ao usuário

Síntese Crítica

O Design Invisível é a nova gramática do poder: uma arquitetura de escolhas que se apresenta como neutra, mas molda o que percebemos, desejamos e decidimos. A personalização extrema cria a ilusão de autonomia enquanto guia o comportamento por caminhos invisíveis de sugestão e engajamento. Cada clique reforça o próprio labirinto, transformando liberdade em trilho. O perigo não está mais na manipulação explícita, mas na naturalização da influência: quando o algoritmo parece entender melhor nossos desejos do que nós mesmos. A conveniência se torna anestesia cognitiva, um prazer sem pausa que, em troca da fricção do pensamento, oferece previsibilidade e conforto. No fundo, não somos apenas usuários, mas personagens em roteiros escritos por métricas de atenção.

Mitigar essa erosão da autonomia requer revelar a coreografia oculta da tecnologia. Precisamos de design que devolva agência ao usuário — interfaces que expliquem suas lógicas, permitam o erro e restituam o direito de não escolher. O combate ao design invisível é também um projeto político: transparência algorítmica, rastreabilidade de conteúdo sintético e letramento cognitivo são as novas formas de alfabetização democrática. Cada vez que entendemos “por que vimos o que vimos”, abrimos uma fenda na invisibilidade. E nessa fenda renasce o livre-arbítrio, não como resistência romântica à máquina, mas como exercício cotidiano de consciência diante dela.

Para saber mais

Comentários da Comunidade

Seja o primeiro a comentar!

Adicione seu comentário